Đồng bộ dữ liệu với Bigquery

Tài liệu hướng dẫn thao tác sync data từ PangoCDP lên Google BigQuery từ PangoCDP

Google BigQuery là gì?

Google BigQuery là một kho dữ liệu (data warehouse) trên nền tảng điện toán đám mây của Google (Google Cloud) cho phép bạn chạy các truy vấn siêu nhanh trên các tập dữ liệu lớn. BigQuery hoạt động dưới dạng nền tảng là một dịch vụ (Platform as a Service – PaaS) trên hạ tầng của Google nên được thừa hưởng nhiều công nghệ hiện đại và tiên tiến. BigQuery hiện nay đã trở thành một trong những data warehouse được sử dụng nhiều nhất trên thế giới

Các bước thao tác Sync Data lên Google BigQuery

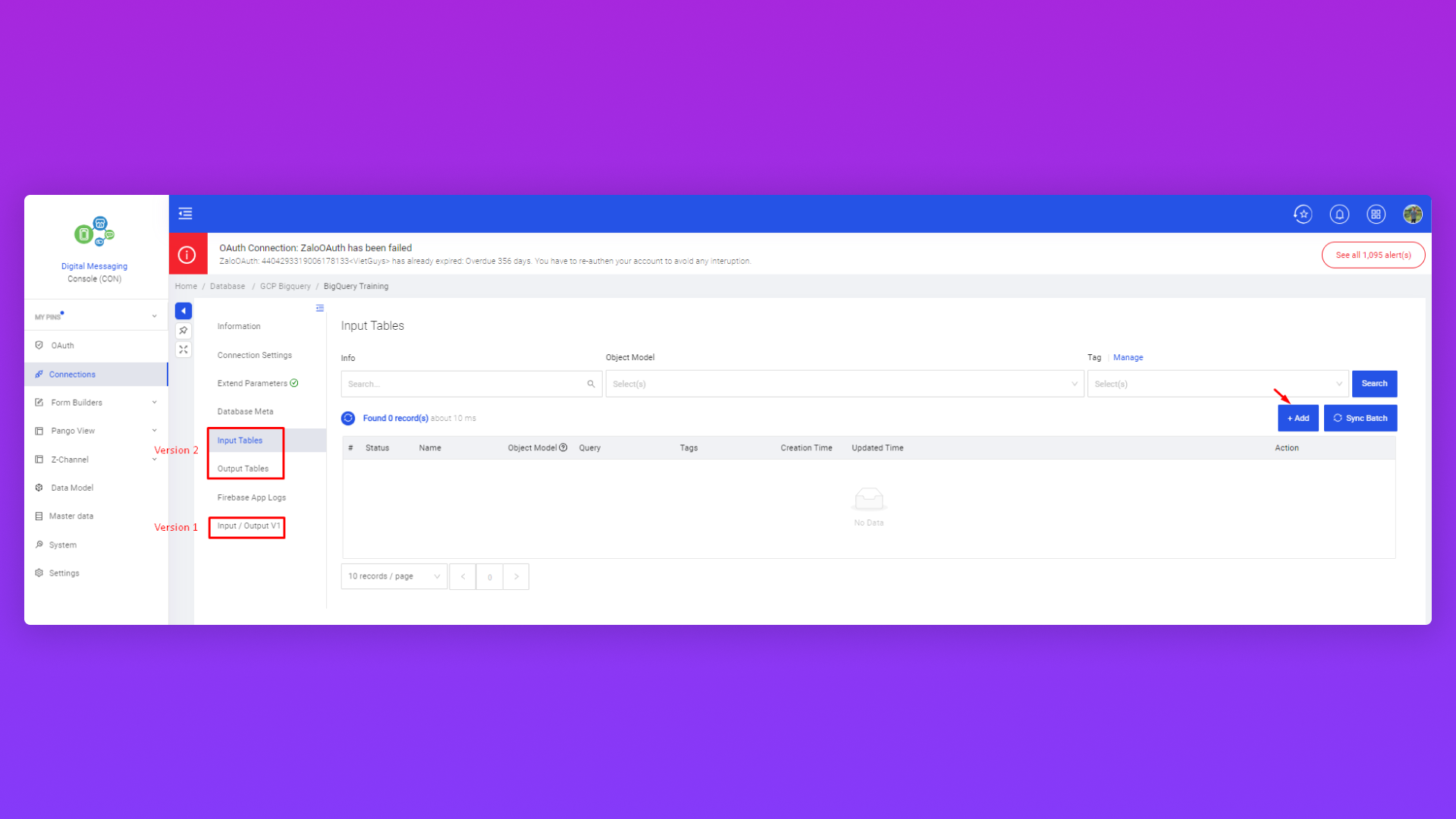

Bước 1: Tạo Connect Big Query

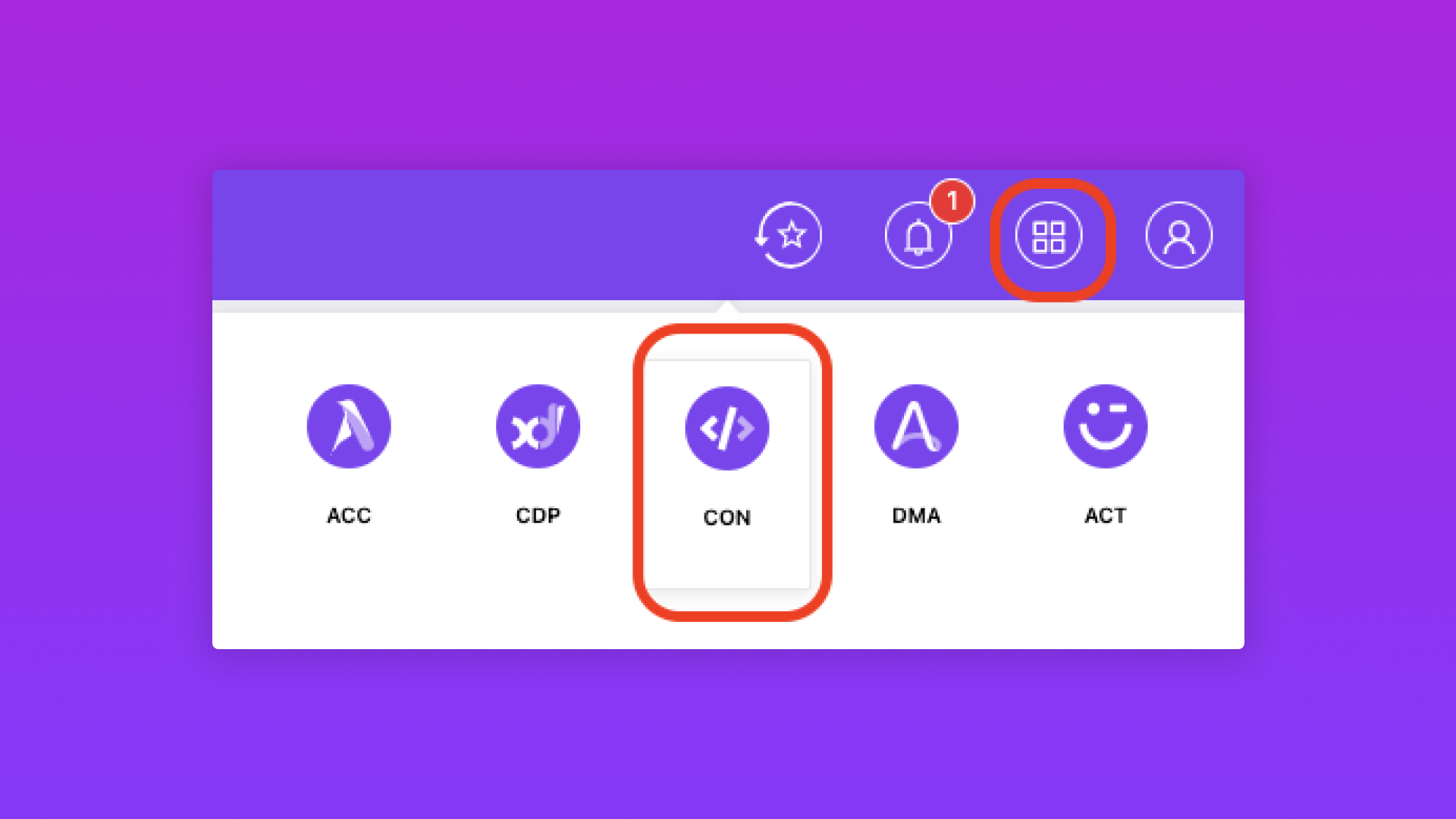

Vào Module Console

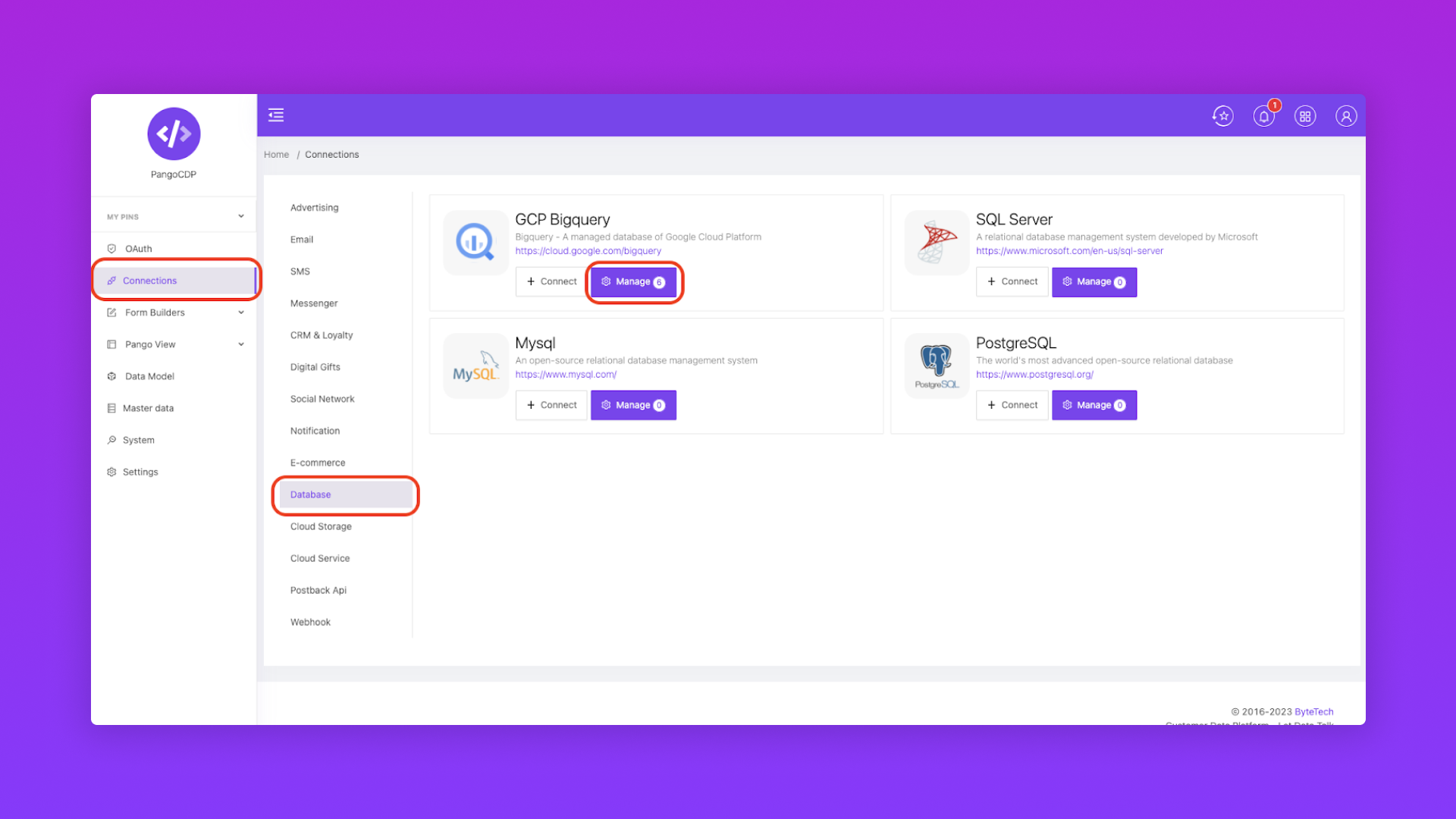

Chọn Database

Chọn GCP BigQuery

Bước 2: Thiết lập thông tin kết nối và kiểm tra dữ liệu

Vào Module Console

Chọn Connection

Chọn Database

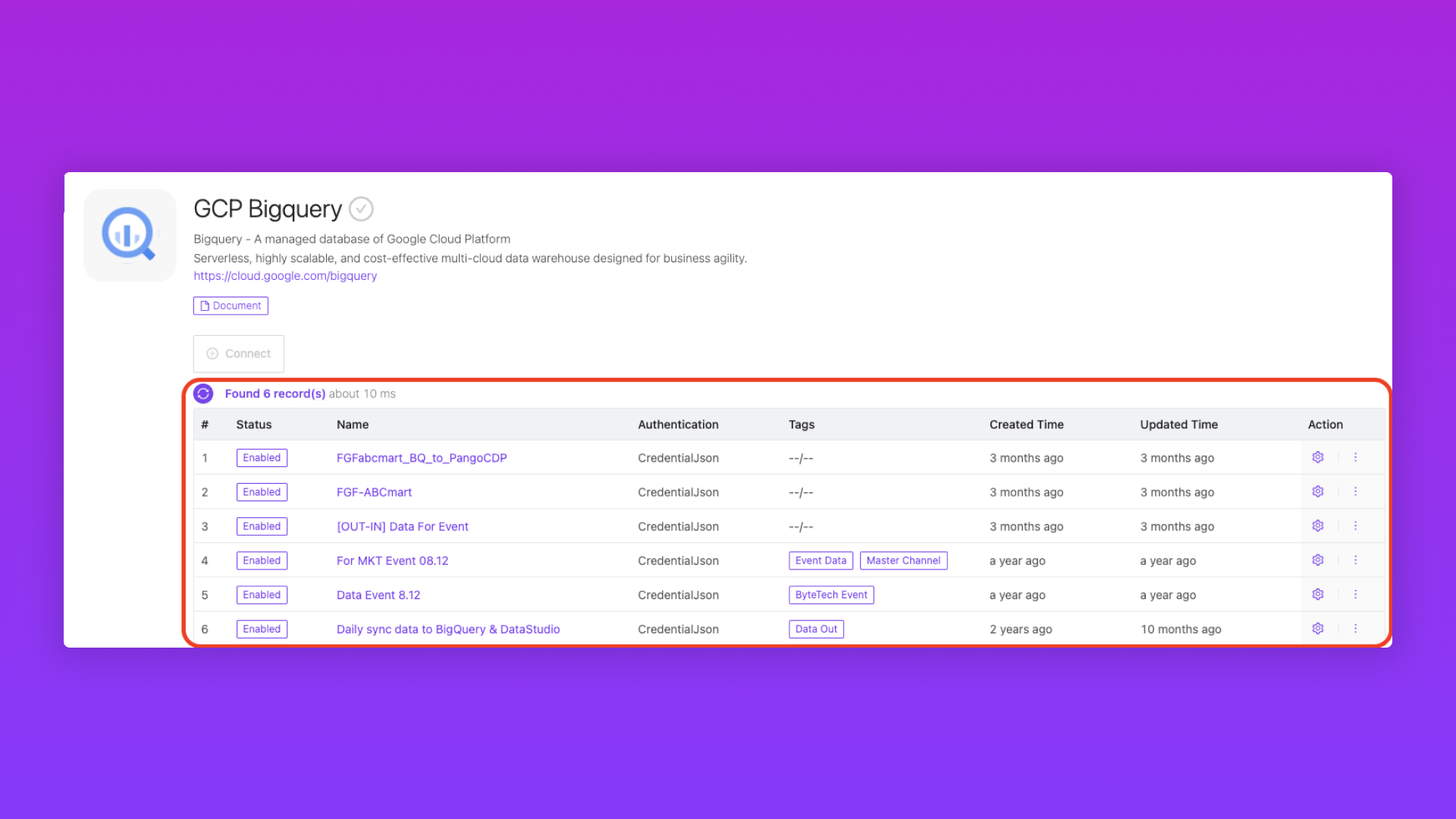

Chọn Manage và kênh BigQuery

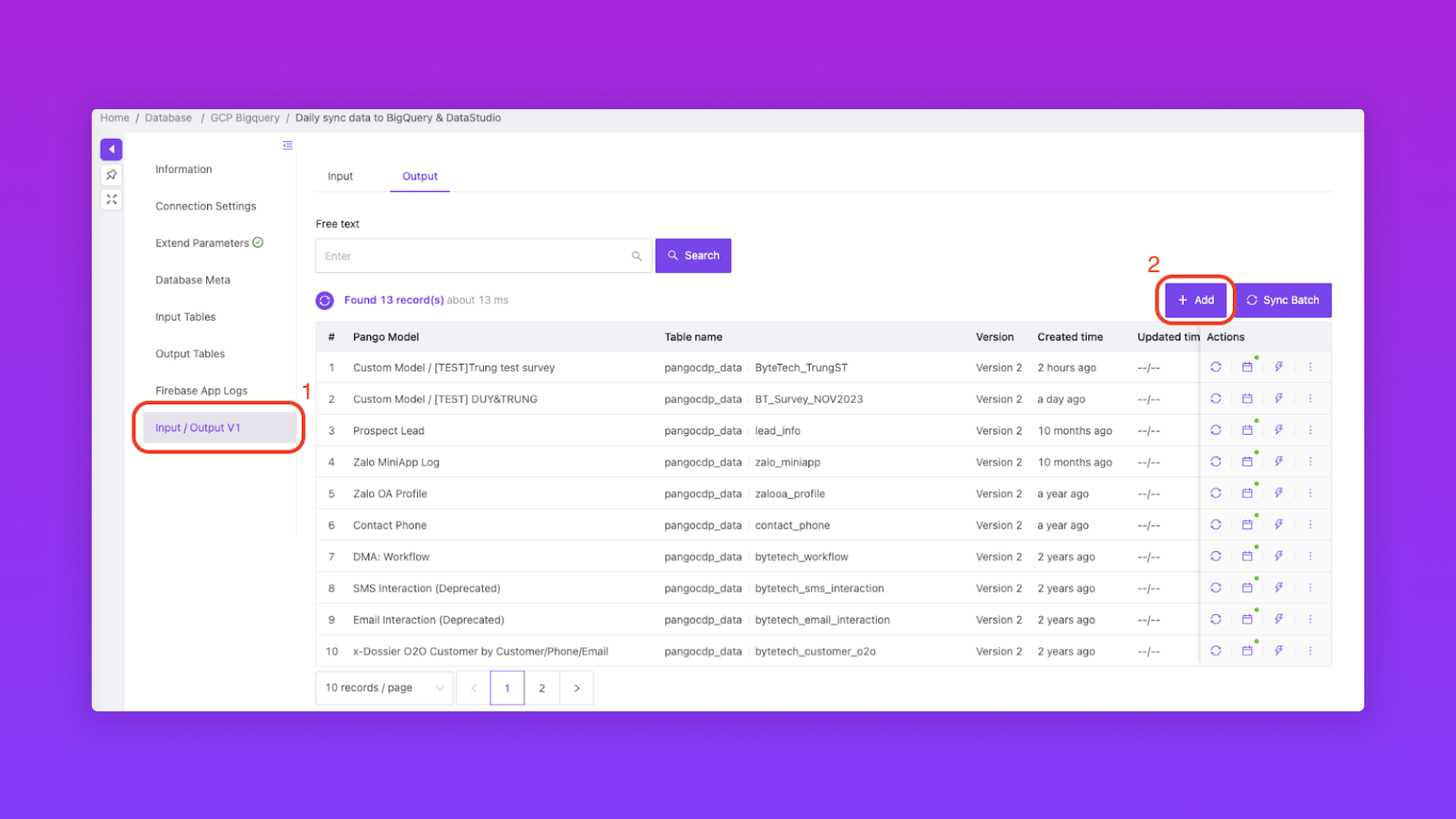

Tạo Table và điền thông tin

Để kiểm tra dữ liệu đã được sync lên Google BQ thì truy cập vào link

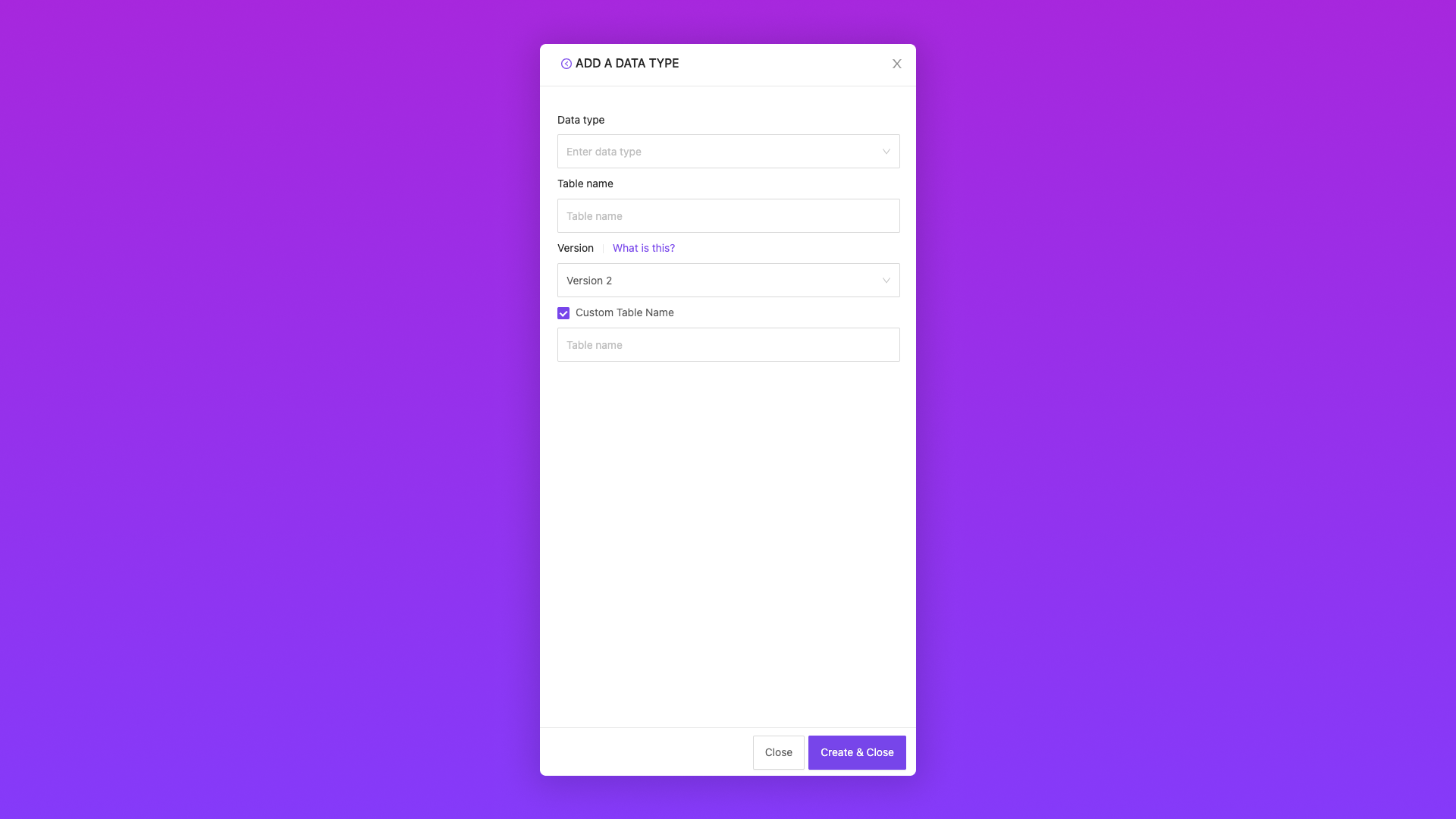

Data type

chọn Data Model muốn push lên GG BigQuery

Table name

sẽ tự sinh ra sau khi chọn Data type

Version

chọn Version BigQuery Pango

Version 1: tất cả các customField sẽ được gôm và nằm trong cùng 1 Field. Sau khi Push lên GG BQ sẽ dùng công thức tách chuỗi ra từng Field

Version 2: tất cả các customField trên Data Model sẽ được giữ nguyên riêng biệt sau khi đẩy lên GG BQ và không cần dùng công thức tách chuỗi

Custom Table Name

dùng để đặt tên bảng table trên GG BQ sau khi dữ liệu được push

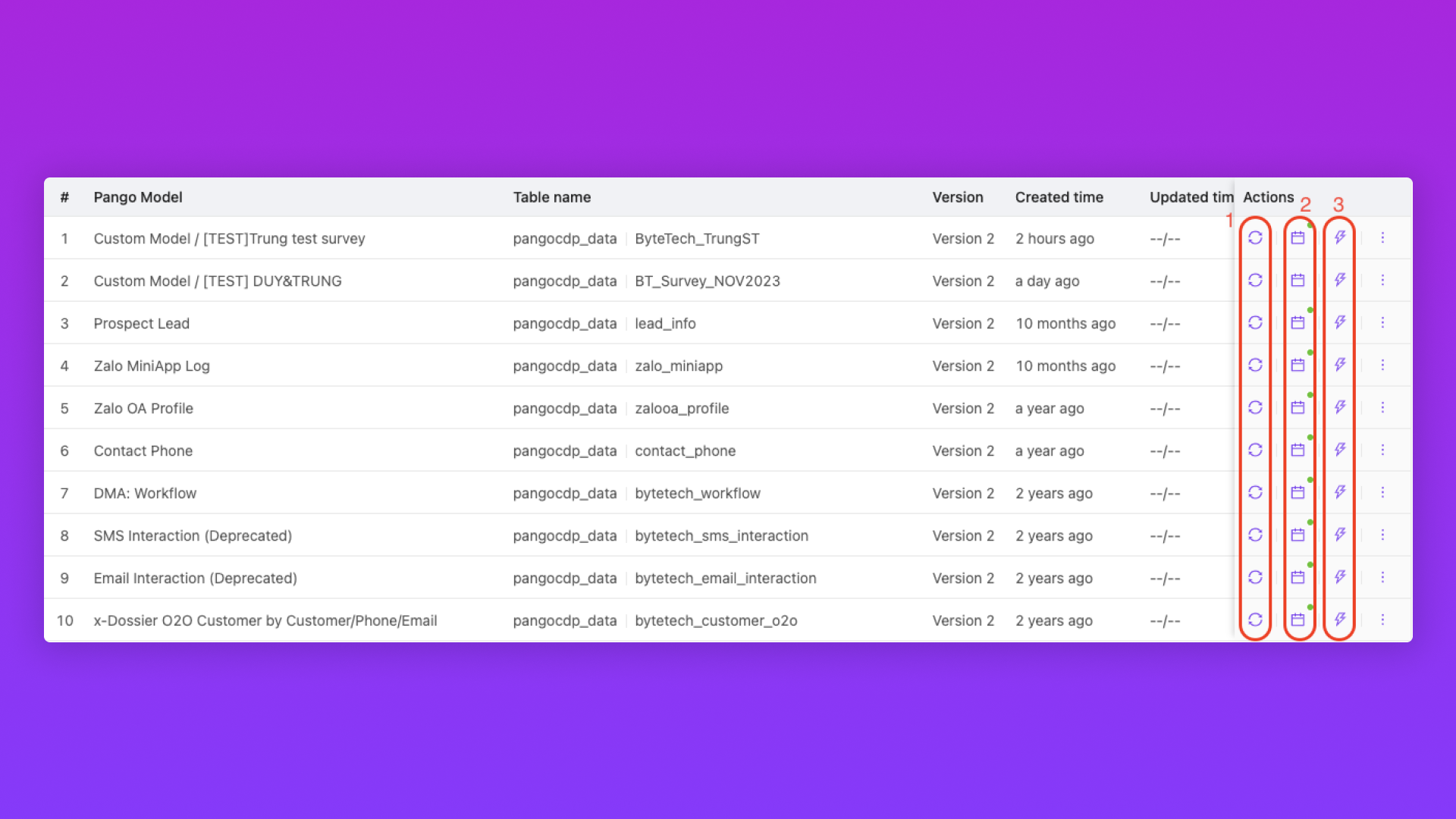

(1) Feed data to BigQuery

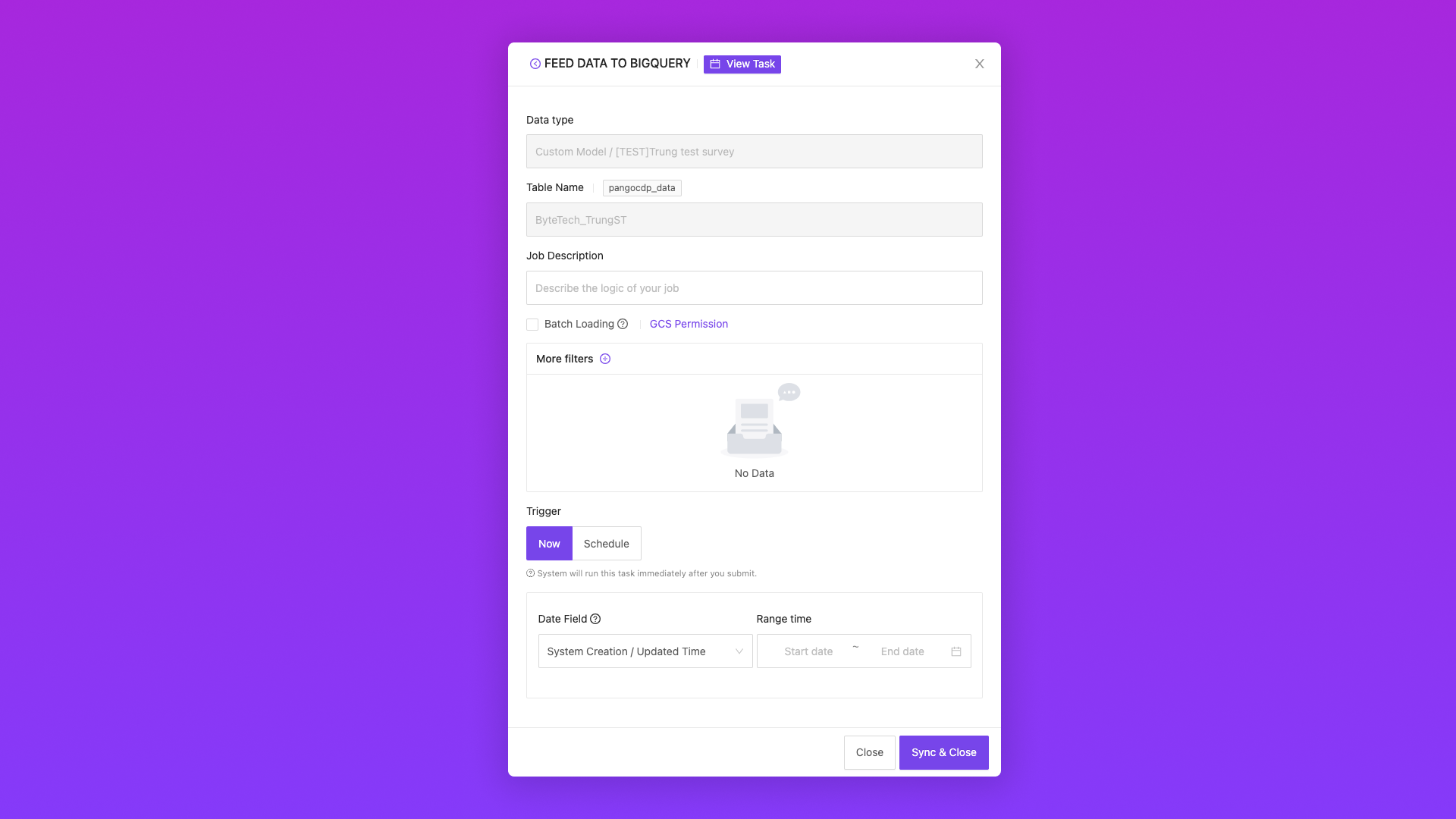

Data type

Data Model được chọn để push lên GG BigQuery

Mặc định hiển thị tự động

Table name

sẽ tự sinh ra sau khi chọn Data type

Mặc định hiển thị tự động

Job description

mô tả về dataset

Batch Loading

dùng để đẩy theo từng Batch Data (phân tách thành nhiều phần và Push data lên Google BQ, thường áp dụng cho push data số lượng lớn).

Google BQ thì các Batch được push lên sẽ không có cập nhật thông tin để người dùng biết nên ít khi dùng chức năng này.

More filters

thêm điều kiện lọc về data muốn feed vào dataset (các field đã tạo ở Data model)

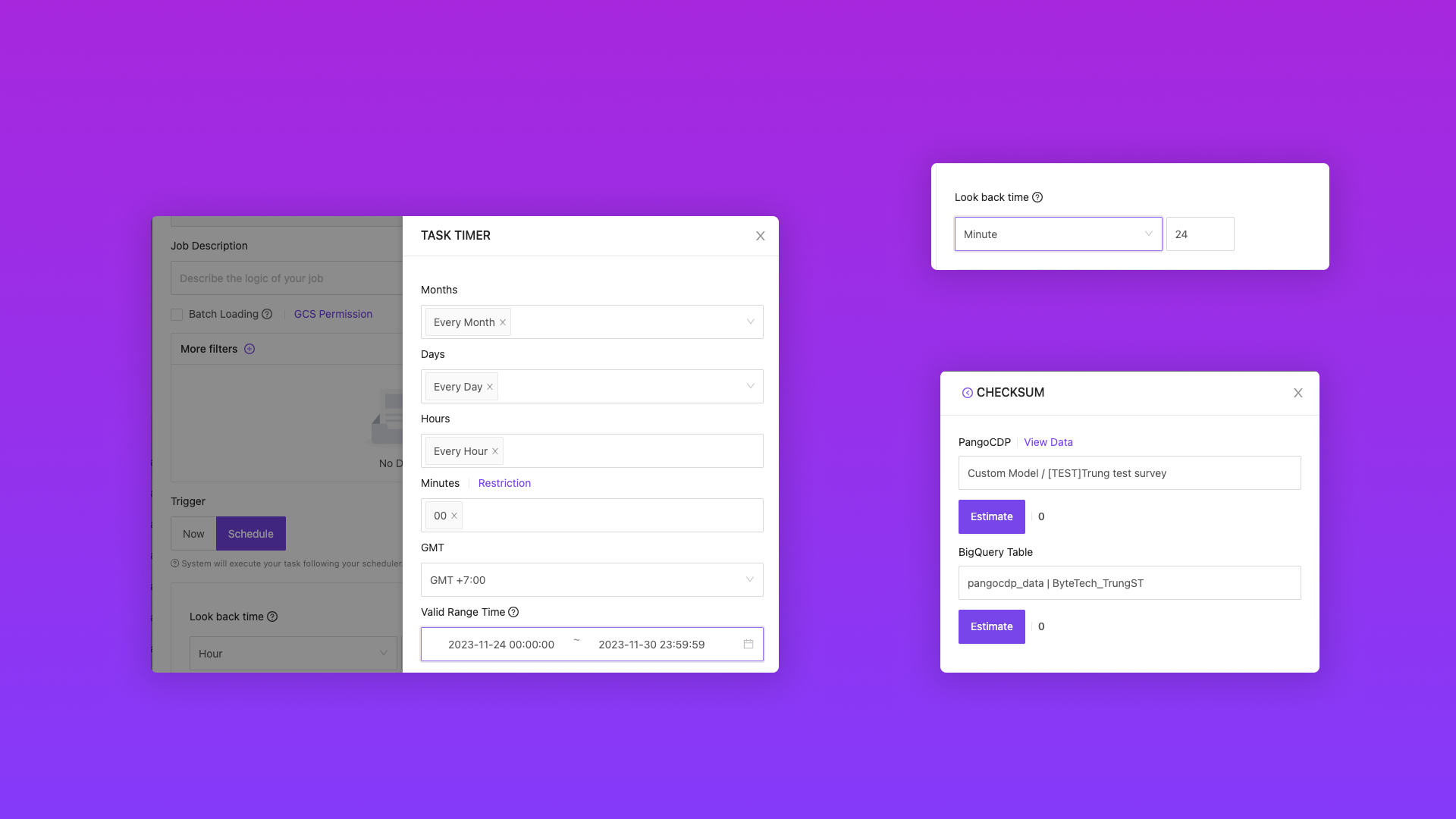

Trigger

chọn thời gian để push dữ liệu

Instance: Chọn khoảng thời gian cụ thể và feed data lên dataset BigQuery ngay lập tức

Schedule: Đặt lịch, chọn khoảng thời gian cụ thể cho hệ thống tự động feed data lên Bigquery ( trường hợp dưới đây là feed data mỗi giờ, ví dụ: 3:00, 4:00,…)

Look back time

là tổng khoảng thời gian mà hệ thống sẽ lấy mỗi khi bắt đầu chạy auto feed data

Ví dụ khi chúng ta chọn khoảng thời gian mà hệ thống sẽ tự động feed data là mỗi giờ vào lúc :00’ thì đúng khi bước qua giờ mới hệ thống sẽ chạy quét dữ liệu từ giờ trước đó ( 3h-4h thì sẽ là dữ liệu từ 03:00 - 04:00 là 60’) nhưng từ đoạn thời gian bắt đầu quét và push lên Bigquery thì sẽ tốn một khoảng thời gian tuỳ thuộc vào lượng data(ví dụ trong trường hợp này là 5’) nên thay vì chúng ta quét 60’ thì chúng ta sẽ quét 65’ để có thể hold được lượng data bị miss trong khoảng thời gian mà hệ thống xử lý lượng data từ giờ trước đó

Sẽ có một số mốc thời gian để có thể dễ hình dung

Mỗi giờ: 65’

Mỗi ngày: 25h

Và đây sẽ là 2 khoảng thời gian thường gặp nhất

(2) View task

view lại những task đã chạy trước đó ( feed now hoặc feed schedule)

(3) Check sum

Kiểm tra lại lượng dữ liệu trong model Pango và lượng dữ liệu đã push lên Bigquery

Warning: Thường thì khi feed data lên Bigquery thì sẽ feed all data đang có sẵn cho lần đầu tiên để đảm bảo đầy đủ. Sau lần đầu sẽ dùng schedule - đặt lịch feed định kỳ.

Was this helpful?